انتروپی یکی از سهل ممتنعترین مفاهیم فیزیکه. همه فکر میکنند که میدونند چیه و همه همزمان درست نمیدونند که چیه! مسئله انتروپی و پیکان زمان هنوز جزو مسائل حل نشده در فیزیکه. قانون دوم ترمودینامیک ارتباط تنگاتنگی با این مفهوم داره و از قضا این قانون، جای پای خیلی محکمی توی فیزیک داره. برای همین انتظار میره که بدونیم انتروپی چیه، نه؟! بعضیها به اشتباه قانون دوم رو تفسیر به زیاد شدن بینظمی میکنن که لزوما درست نیست.

انتروپی یک کمیت قابل اندازهگیری و یک متغیر جفتشده (همیوغ) برای دما در ترمودینامیکه. از طرف دیگه، به واسطه توسعه مکانیک آماری، تعریفهای جدیدتر با فرمولبندیهایی بر اساس توزیعهای آماری برای بیان انتروپی یک سامانه بر اساس حالتهایی که میتونه داشته باشه ارائه شده. وصل کردن فیزیک آماری به نظریه اطلاعات معمولا با کارهای جینز شناخته میشه. اما از لحاظ مفهومی و فلسفه علمی، آزمایش فکری شیطانک مکسول برای اولین بار این درک رو ایجاد کرد که اطلاعات یک کمیت فیزیکیه.

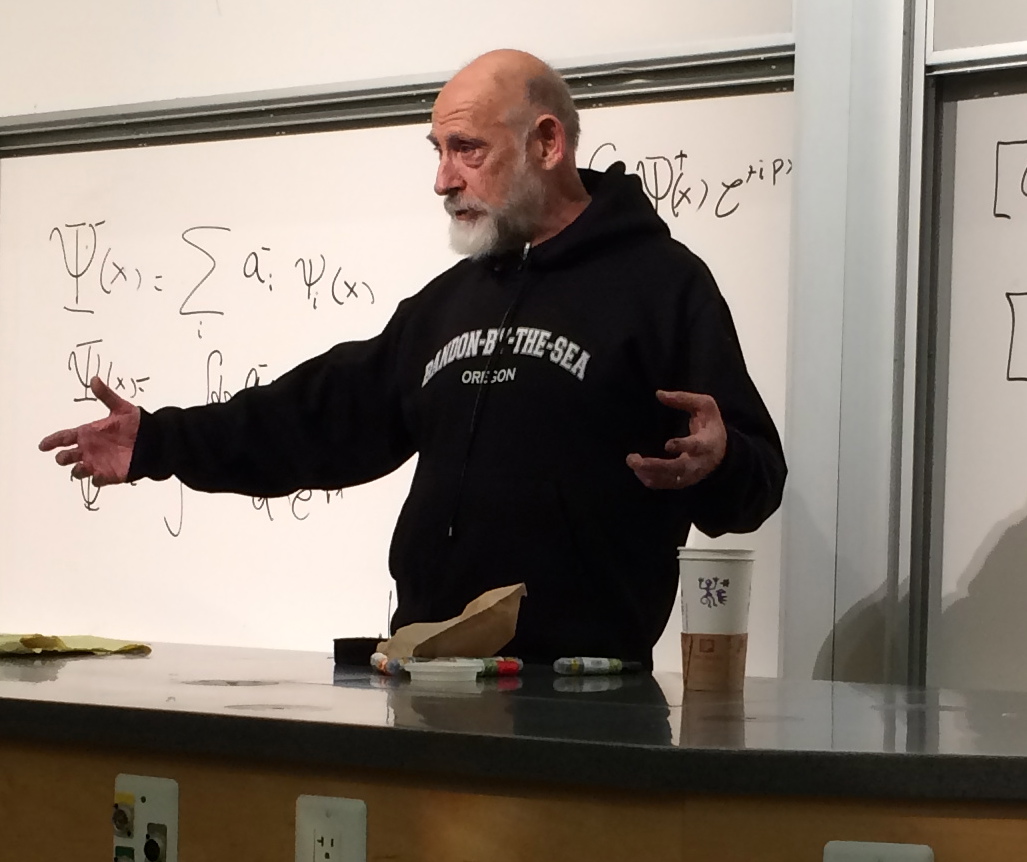

I will try to explain the second law to the best of my ability. There should be lots of questions which I will try to answer. I know a little bit about the second law; it may be two or three people in the world who know more, but I’ve never met any, so we’ll talk a little about the second law [and] what it means

Leonard Susskind, Statistical Mechanics (Spring, 2013), Lec. 7: Entropy vs. reversibility

دنبال کردن تغییرات انتروپی به صورت نظری یا تجربی در فیزیک تعادلی و غیرتعادلی متفاوته. برخلاف انتظار ما، اندازهگیری تغییرات انتروپی در تعادل میتونه کار خیلی سختی در آزمایشگاه باشه. در فیزیک دور از تعادل، روابط افتوخیز چارچوب به نسبت معقولی برای مطالعه انتروپی به ما میده.

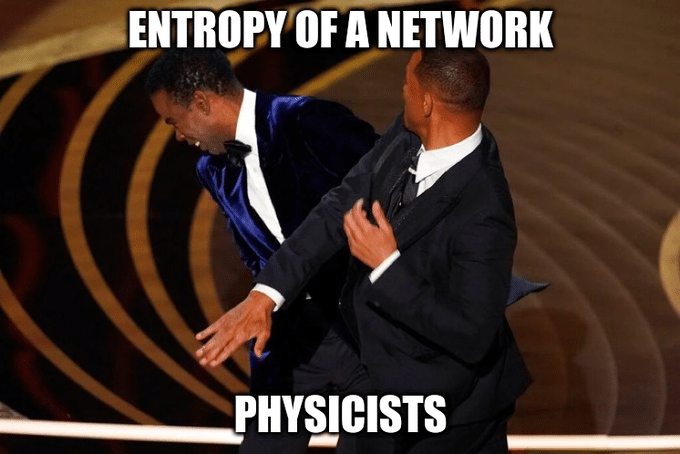

انتروپی برای همگردی (ensemble) از چیزها معنی داره. انتروپی یک مولکول چندان چیز معنا داری نیست، بلکه انتروپیحالتهایی که یک مولکول میتونه داشته باشه عبارت معنی داریه. با نگاه کردن به فرمول شنون هم خیلی راحت میشه دید که برای یک توزیع خاص میشه انتروپی تعریف کرد. مثال دیگه، که یک مثال فیزیکی نیست، صحبت کردن در مورد انتروپی شبکههای پیچیده است. انتروپی یک شبکه میتونه منجر به گمراهی مخاطب بشه. چون مشخص نیست که این انتروپی به توزیع درجه اون شبکه برمیگرده یا همگردی از گرافها یا چی!؟ مثلا قاعده انتروپی بیشینه برای همگردی از گرافها با چگالی یال ثابت منجر به مدل اردوش رنیی میشه. این مدل، شبکهای با توزیع درجه پواسونی میده که اون توزیع، توزیع بیشترین انتروپی نیست!

نکته بعدی اینه که انتروپی یک کمیت فردیه (subjective) به این معنا که ربطی به قوانین بنیادی طبیعت و برهمکنش ذرات با هم نداره. معمولا کسایی که بعد از گذروندن درس مکانیک کلاسیک وارد درس مکانیک آماری تعادلی میشن با این سوال رو به رو میشن که طبق تعریف، لگاریتم حجم فضای فاز (در یک انرژی خاص) برابر با انتروپیه. از طرف دیگه قضیه لیوویل میگه که برای یک سامانه طی زمان، هندسه فضای فاز عوض میشه ولی حجمش نه! پس یعنی انتروپی ثابت میمونه! آیا این مشکلی داره؟! اول اینکه قانون دوم ترمودینامیک میگه که انتروپی یک سامانه بسته در حد ترمودینامیکی تقریبا هیچموقع کم نمیشه، یعنی $\mathrm{d}s$ یا صفره یا مثبت. پس کی $\mathrm{d}s>0$ هست؟ ایده اصلی اینه که انتروپی یک کمیت وابسته به سامانه و ناظره. در واقع انتروپی رو طی فرایند درشت-دانهبندی اندازهگیری میکنیم و این ما (ناظر) هستیم که انتروپی رو زیاد میکنیم!

خلاصه خیلی مهمه که در چه شرایطی و برای چه سامانهای (اندازه و نوع برهمکنشها) داریم صحبت میکنیم. انتروپی میتونه خیلی خیلی موضوع ظریفی باشه خصوصا وقتی که دور از تعادل هستیم. در سامانههای کوچیک مثلا انتروپی میتونه کم یا زیاد بشه. برای دونستن بیشتر به اینجا و اینجا نگاه کنید.